和去年“端到端”占据智驾几乎所有话语权不同,今年夏天以来,VLA(Vision-Language-Action)的争论日趋激烈。品牌高管、专家、技术线“高P”们纷纷下场。以前业内智驾竞争,更多通过产品说话,技术观点直接碰撞较少。现在,大家对沿着VLA能否迭代到L3、L4智驾,产生了判断分歧。

当然,技术话语权的争夺,最终也要在消费市场上兑现。9月份,华为将向用户全量推送乾崑智驾ADS 4;小鹏也将在9月量产推送VLA,再加上刚刚发布VLA系统的元戎启行,以及声称“量产”VLA产品的理想,8月份VLA话题火爆,再合理不过。

新的智驾阵营形成

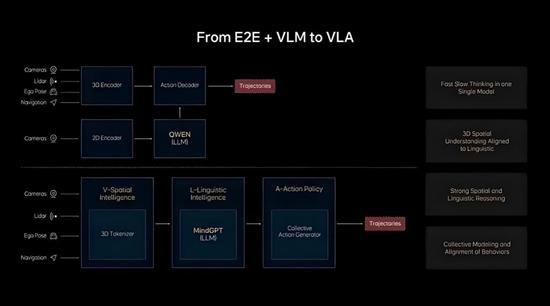

到底什么是VLA?字面意思,就是“视觉-语言-行为”链,也是个大模型。实际上就是将视觉信息作为输入,问一个大模型如何开车(这里的大模型单指LLM)。这看上去似乎在模拟人类开车的方式。基本上,VLA的信徒也动辄到人类思维和行为模式当中寻找灵感。

简单看,VLA分四步:识别图像;将图像理解,翻译成语言文本(Token),输入大模型;大模型给出驾驶建议;将建议生成轨迹+环境,修正建议。

8月8日世界机器人大会上,王兴兴(宇树科技CEO)表示,“VLA是相对傻瓜式的架构”。王兴兴还表示,VLA过度依赖高质量数据,适应性差、泛化差。他预言无法突破“临界点”(放在智驾上,就是无法直升L4)。

VLA这些短板,小鹏、理想、元戎启行等坚持VLA路线等企业都深有体会,但考虑到C端可能的反应,免不了有些不爽。尤其是持续向公众宣传VLA的理想。

舆论这边刚骂完王兴兴“不懂”,华为车BU CEO靳玉志又公开表示,华为不会走VLA路线。“VLA看似取巧,并不是最终走向真

正自动驾驶的路径,我们更看重WA(World Action世界行为模型),省掉了”语言“环节”。

这番论调更“暴”,直接否定了VLA。这下子,阵营壁垒变得分明:VLA+RL(强化学习)VS世界引擎(云端)+世界行为模型(车端),后者华为牵头。

VLA的优势和短板

王兴兴还少说了一点,那就是长思维链的VLA很慢,车端反应是秒级的,只适合非时敏型任务,比如泊车;而短思维链(比如3到4层),则处理长尾场景的能力不够强,且仍然不够快。理想团队因此升级为“快慢系统”:用不依赖思维链的端到端系统,针对结构性场景,负责“轻量化”驾驶;而VLA模型,则优化为特殊定制的思维链。VLA派认为,人脑开车的时候,也存在“快慢系统”。

如何“特殊定制”才能缩短反应时间呢?无非是小词表(Token数量少)、并行解码、逻辑推理,然后将行为Token一次性输出。

即便如此,VLA在长尾场景中的反应速度仍然可疑。反应速度也好,车端模型大小也好,都受到车端算力、内存带宽的严厉制约。Waymo做L4的时候,相当简单粗暴,在后备箱里直接塞俩A100(单张FP32稠密算力峰值19.5TFlops,带宽1.6TB/s)。对于量产车而言,A100这样的算力未免太贵。英伟达的Thor(FP4稀疏算力峰值2070TFlops,相当于A100算力的1%)再次跳票之后,算力提升就需要自己来解决。所以我们看到蔚小理、小米都有自研算力芯片项目。

就因为有语言翻译这一环节,有人将其看做“两段式”端到端。在一些复杂场景中,比如极限遮挡,比如临道前方大型车辆对本方视野的限制。这个时候人来开车的话,往往提倡防御性驾驶,大语言可以准确描述这种遮挡。对于人类都头疼的潮汐车道、长时序推理等特殊场景,VLA表现得很好。但对于一些简单场景,视觉语言大模型反而可能出现常识性错误,这和语言大模型的幻觉如出一辙。我们多次见过,大模型为了完成任务,不惜伪造数据和逻辑链。当然,它根本不知道什么是“伪造”,只是预测Token出现偏差而已。

也有人称,3D转2D(比如用3D高斯溅射,一种将实时环境点云转换为高斯分布的数学方法)过程中,语言往往不能很好描述所有场景。即人眼看到的很多细微差别,特别是低像素物体,语言是相当乏力的(比如远处只占2个像素的锥桶)。问题就在于,99%情况下结果收敛是完全不够的。

因此,VLA面临的问题,可以简化为数据质量依赖和效率问题(思考太久)。

世界模型:看上去很美

而“世界模型派”认为,采用世界模型,可以避免过度依赖高质量数据。理论上,世界模型,是用数学方式模拟现实物理世界。但在智驾领域内,World Model到底world了个啥,还存在争议。

3D高斯当然不完美,但3D高斯不仅包含了点的位置信息,还描述了点云在空间形状、分布、大小(用协方差矩阵),以及颜色、透明度。这些物理描述基本具备世界模型的表征。同理,坚持世界模型的企业,往往也偏爱激光雷达。这也是为什么我们看到,纯视觉与激光雷达的拥趸,也有点势不两立的味道。

鉴于世界模型能够生成数据(质量另说),显然可以完成预训练和仿真,基于世界模型可以实现端侧推理。这时候所谓推理,就是在虚拟世界中预测未来。如果虚拟世界与现实世界贴合得很紧,那么也意味着可以预测物理世界未来的几秒钟。

理论上,世界模型拥有对世界更好的理解力,思考也很快(因为没有语言描述这一步)。靳玉志认为,世界模型将信息(不局限于视觉信息)给大模型,后者直接输出行为指令控车。看上去很完美。

但是,虽然世界模型对真实长尾数据量没太多要求,但既然靠生成数据进行训练,就仍对数据质量有要求。如果这些数据描述物理互动偏差过大,基于这些有缺陷数据,训练出来的系统,可能带来难以估量的隐患。同时,世界模型不像VLA那样,决策过程可见、可理解。出了问题,只能回溯到训练之前。

不同代际竞争并存

现在双方都坚持自己的路线能走到L4。VLA的挑战在于,如何用“语言”描述复杂空间互动。如果算力无限,可能不再是问题。而世界模型则试图解决空间认知和物理推演问题,但生成了模型之后,就很难控制训练质量。两种技术,无论描述的如何花团锦簇,当前都处于幼年期。

和occ、BEV不同,这一回学术界也没摸清楚VLA和世界模型的潜力。在学术界还没底的情况下,工程界就开始落地商业化了。后者先动手,而不是等技术理论支撑完善,表明当前智驾的竞争已经开始压迫生存力了。看清楚、想明白再下手,可能就“没仗可打”,意味着商业机会的丧失。

这种趋势倒是明白无误的,明年头部智驾的竞争,极大概率将转移到VLA与世界模型“路线斗争”上来。考虑到一些厂商,还没搞定规控路线,即便身处于同一个市场环境,也不再是一个维度的竞争了。我们正看到,“机械化战争”与“骑马砍杀”并存。说实话,倒退3年,都无法想象技术竞争的现实,是如此的魔幻。

最终,哪种路径能率先成功,取决于技术瓶颈的突破速度、算力成本的下滑曲线以及大规模路测反馈的迭代效率,时间会给我们最终的答案。在寻求越过L2藩篱的过程中,消费者掏钱尝鲜,能否率先体验到优于现有水平的智驾,尚不确定。

免责声明:本站登载此文仅出于信息分享,并不意味着赞同其观点及其描述,不承担侵权行为的连带责任。如涉及版权等问题,请与我们联系(联系QQ:26887486),我们将及时删除处理。

本文链接:https://www.yunlianauto.com/article/53/52482.html