近日,智元机器人推出行业首个面向真实世界机器人操控的统一世界模型平台 Genie Envisioner(GE),并宣布将开源全部代码、预训练模型及评测工具。

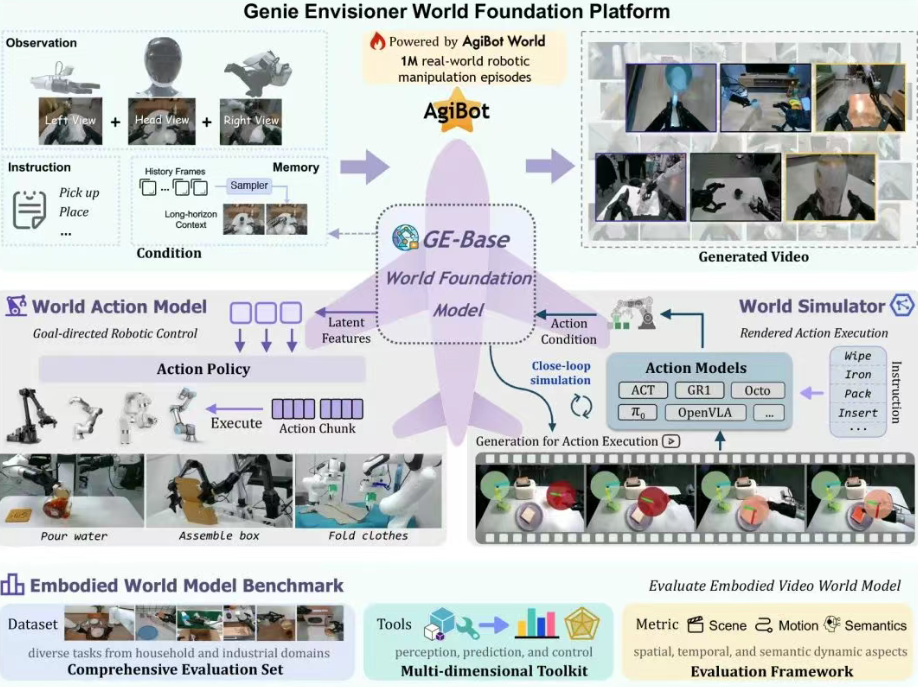

该平台创新性地将未来帧预测、策略学习与仿真评估整合进以视频生成为核心的闭环架构,首次实现机器人在同一世界模型中完成从感知到决策再到执行的端到端推理流程。

图片来源:智元机器人

传统机器人学习系统普遍采用"数据收集—模型训练—策略评估"的分阶段开发模式,各环节相互独立且依赖任务特定调优,导致开发复杂度高、迭代周期长。

GE平台通过构建统一的视频生成世界模型,破解了这一碎片化架构瓶颈。基于约3000小时的真实机器人操控视频数据(涵盖超100万条真机记录),平台建立了语言指令到视觉空间的直接映射,完整保留机器人与环境交互的时空动态信息。

核心突破在于视觉中心的世界建模范式。区别于主流VLA(Vision-Language-Action)方法依赖语言抽象,GE直接在视觉空间中建模机器人与环境交互动态,实现对物理规律的精准捕捉。这一范式带来显著性能跃升:

跨平台泛化效率提升:在Agilex Cobot Magic等全新机器人平台上,GE-Act动作模型仅需1小时(约250个演示)遥操作数据即可高质量执行任务,优于需大规模多本体预训练的π0和GR00T模型;

长时序任务执行突破:在折叠纸盒等超10步连续任务中,GE-Act成功率高达76%(π0为48%,UniVLA/GR00T为0%),关键归因于视觉空间显式建模时空演化的能力及创新的稀疏记忆模块设计。

技术架构由三大协同组件构成:

GE-Base多视角视频基础模型:采用自回归视频生成框架,通过头部与双臂腕部三路视角输入保持空间一致性,结合稀疏记忆机制增强长时序推理。训练分两阶段:3-30Hz多分辨率时序适应训练提升运动鲁棒性,5Hz固定采样策略对齐微调;

GE-Act平行流匹配动作模型:160M参数轻量架构通过交叉注意力机制将视觉表征转换为控制指令,采用"慢-快"异步推理(视频DiT 5Hz/动作模型30Hz),在RTX 4090 GPU实现200毫秒54步实时响应;

GE-Sim层次化动作条件仿真器:通过Pose2Image条件与运动向量编码,将控制指令精确转换为视觉预测,支持闭环策略评估与数据生成,每小时可完成数千次策略rollout。

为量化世界模型质量,团队同步推出EWMBench评测套件,从场景一致性、轨迹精度等维度评估建模能力。在Kling、OpenSora等模型对比中,GE-Base在关键指标均领先且与人类判断高度吻合。平台现已开放项目主页、论文及代码仓库,推动具身智能从"被动执行"向"想象—验证—行动"范式演进。

免责声明:本站登载此文仅出于信息分享,并不意味着赞同其观点及其描述,不承担侵权行为的连带责任。如涉及版权等问题,请与我们联系(联系QQ:26887486),我们将及时删除处理。

本文链接:https://www.yunlianauto.com/article/53/52301.html